人工智能(AI)的发展一直建立在这样的信念之上:训练数据规模越大,模型就会越来越好。然而,业界近期曝出了大模型进化遭遇“数据墙”的消息。

据外媒报道,OpenAI、谷歌和Anthropic在AI模型开发方面都陷入了瓶颈,他们发现,新模型无法像前面几代产品那样带来巨大的飞跃。这在AI圈瞬时炸开了锅。

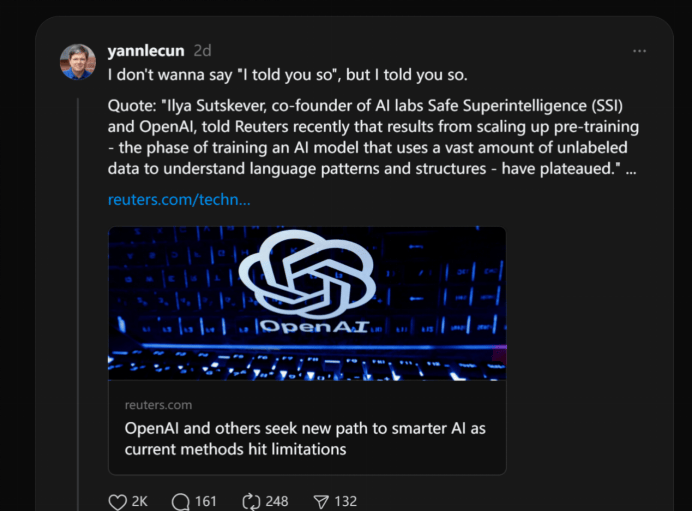

图灵奖得主杨立昆(Yann LeCun)和OpenAI前首席科学家伊利亚·苏茨克维(Ilya Sutskever)等科技圈大佬不客气地指出,大模型的规模法则(Scaling Law)已经达到极限,必须转变思维,改变训练模式了。

而OpenAI CEO阿尔特曼(Sam Altman)和Anthropic CEO达里奥·阿莫迪(Dario Amodei)都相继对“瓶颈”说进行反驳。尽管如此,OpenAI和谷歌都在积极转变策略,研究如何解决训练数据匮乏的问题,以及如何调整规模法则的应用,保持模型稳步发展。

在百度CEO李彦宏看来,模型开发放缓也不见得是一件坏事。在最近的一次访谈中,他表示,基础模型早期快速迭代是正常的,但如果两年、三年了还这样,那整个生态其实是会比较乱。Meta CEO扎克伯格也表示,即使在现有技术的基础上,应用层面依然有很大的发展空间。

图片来源:视觉中国-VCG41N1309760279

OpenAI、谷歌和Anthropic遭遇开发瓶颈

据外媒,OpenAI的下一代旗舰模型可能不会像前面几代产品那样带来巨大的飞跃。

测试代号为Orion的新模型的员工发现,尽管新模型性能超过了OpenAI现有的模型,但进步程度并不如从GPT-3到GPT-4的进步那么大。换句话说,OpenAI改进的速度似乎正在放缓。

OpenAI并不是唯一遭遇阻碍的公司,其竞争对手谷歌和Anthropic也传出了先进AI模型开发遇到瓶颈的消息。在以惊人的速度推出日益复杂的AI产品之后,这三家领先的AI公司现在意识到,他们在开发新模型上进行的大量投入所带来的回报正在逐渐减少。

据知情人士透露,谷歌即将推出的新版Gemini未达到内部预期,Anthropic也推迟了Claude 3.5 Opus模型的计划发布时间。

高质量人造训练数据的缺乏是AI模型开发面临挑战的一大原因。外媒援引两位知情人士称,Orion在编程任务上的表现不尽如人意,部分原因是缺乏足够的编程数据进行训练。即使是有一些小幅的改进,也难以证明新模型构建和运营的高昂成本是合理的,这与市场对于重大升级的期待之间存在差距。

科技圈大佬激辩“数据墙”

AI模型开发遇阻的消息公开后,知名AI评论家加里·马库斯(Gary Marcus)甚至直接单方面宣布“胜利”:“游戏结束,我赢了!我早就说过,GPT正在陷入收益递减阶段。”一直以来,马库斯就预测,生成式AI的发展将进入停滞阶段。

图片来源:X平台

AI怀疑论者经常警告,仅仅通过扩大规模来提高大模型的方法是有限的。一年前,比尔·盖茨就表示,有很多理由相信,当前生成式人工智能(AGI)已经达到极限。“GPT-5不会比GPT-4好多少。”

OpenAI前首席科学家、Safe Superintelligence联合创始人苏茨克维近日在接受外媒采访时也表示,扩大预训练的结果已经达到了平台期。所谓预训练,即使用大量未标记数据来训练AI模型以理解语言模式和结构的阶段。

Meta首席科学家、图灵奖得主杨立昆还转发了苏茨克维这条新闻,并评论,“我早就告诉过你们了,Meta早就开始转型了。”

图片来源:Thread

不过,OpenAI CEO阿尔特曼周四在X上发帖称,“没有墙(there is no wall)”,暗示AI发展没有遇到瓶颈。

图片来源:X

Anthropic创始人、规模法则论文的共同作者达里奥·阿莫迪也在近日的播客中表示,规模法则来自经验而非客观规律,他认为这一法则仍然会继续存在。

科技公司转变策略

尽管阿尔特曼驳斥了“瓶颈”一说,但OpenAI也一直在进行第二手准备。

OpenAI成立了一个基础团队,由之前负责预训练的Nick Ryder领导。该团队主要探索如何应对训练数据的匮乏,调整规模法则的应用,保持模型改进的稳定性。

例如,OpenAI的研究人员开始采用AI生成的合成数据来训练模型。他们还采用了强化学习方法,通过让模型从大量有正解的任务中学习(比如数学或编程问题),以此来改进处理特定任务的方式。此外,OpenAI还尝试在预训练后进行推理,即让模型在回答问题时花更多时间“思考”。OpenAI科学家Noam Brown称它是推理计算的Scaling(扩展)。

图片来源:X

谷歌似乎也在效仿OpenAI的做法。最近几周,DeepMind在其Gemini部门组建了一个团队,旨在开发类似OpenAI推理模型的能力。

谷歌的研究人员也在专注于对模型进行手动改进。参与这项工作的人员表示,改进工作包括改变“超参数”,或者是决定模型如何处理信息的变量,例如模型在训练数据中建立不同概念或模式之间联系的速度。

巨头纷纷转向AI应用

在AI进化遇阻的讨论下,AI应用迎来大爆发。

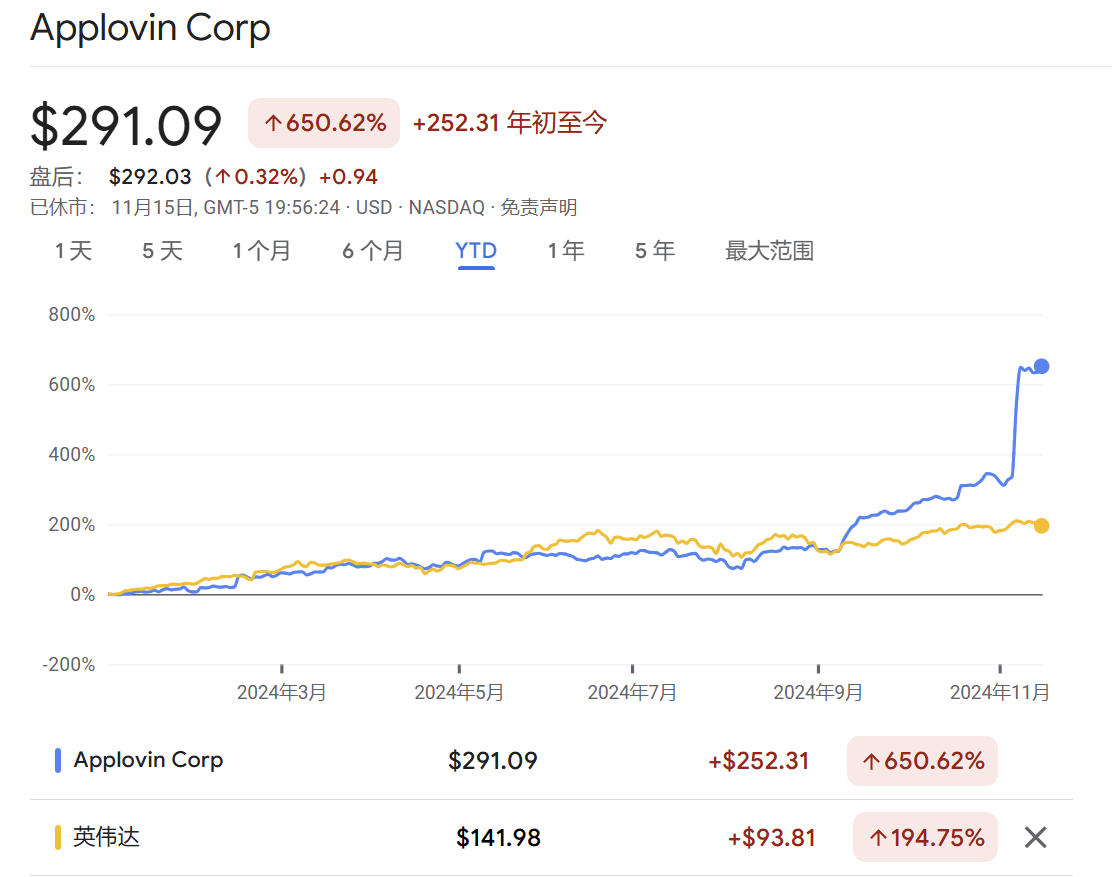

得益于AI广告引擎模型Axon2.0带来的广告匹配效率提升,广告平台公司AppLovin业绩大超预期。年初至今,该股的累计涨幅高达650%,是英伟达同期涨幅的3倍以上,总市值已经接近1000亿美元。

图片来源:谷歌财经

AI平台(AIP)显著推动了Palantir的业务增长。11月15日,这家公司宣布计划将其上市地点从纽约证券交易所转移至纳斯达克交易所。当天,该股涨11.14%,报65.77美元,该股年初至今涨283.05%。

国内AI应用中,字节跳动旗下的豆包年初至今累计下载量已经突破1亿。10月份,Kimi的月活跃用户数突破千万大关。MiniMax海外版应用的10月访问量较上月暴涨2773%。

百度CEO李彦宏认为,AI模型开发放缓也不一定就是个坏事。在最近的一次访谈中,他表示,基础模型早期快速迭代是正常的,但如果两年、三年了还这样,那整个生态其实是会比较乱。

李彦宏解释道:“基础模型不能够特别快地迭代。如果老在变,那做应用的人就无所适从了,该做什么我不知道,我刚做了两个月,你又升级了,把我做的冲掉了,白做了,我又得重新适应一遍新的规则。我觉得可能两年一个大的版本是一个比较合适的节奏。”

扎克伯格也表示,在最坏的情况下,即使技术没有改进,仍然有很大空间在现有技术的基础上打造消费者和企业产品。

作为AI领域的领头羊,OpenAI也在加强对应用层面的探索。据报道,OpenAI将于明年1月推出能够帮助用户整理文件,预订机票的AI智能体(AI Agent)软件。

谷歌正在开发一款代号为贾维斯计划的AI代理软件,“贾维斯”这个名字的灵感来自《钢铁侠》的全能AI管家贾维斯。

黄仁勋也开始对AI应用表达了兴趣。本周,他在日本举行的英伟达AI峰会上和孙正义一起宣布,将联合软银在日本打造AI+5G网络。

同时,他也在会上强调了AI智能体的潜力——即具备理解、推理、规划和执行能力的高级数字智能体,能够改变各个行业的生产力。他指出,这些智能体能够处理复杂的多步骤任务,有望“为人类完成 50% 的工作”,从而大幅提升人类的生产力。通过将数据转化为可操作的见解,代理式 AI 为企业提供了强大的工具,可以在不取代人类角色的情况下提升运营效率。

图片来源:英伟达官网

值得注意的是,英伟达的财报将于北京时间11月21日公布,预计在财报发布后的电话会议上,黄仁勋将宣布更多关于AI应用的消息。

过去一周,英伟达股价的“疯涨”势头暂时有所放缓。

图片来源:谷歌财经

投资公司Roundhill CEO Dave Mazza对《每日经济新闻》记者表示,英伟达需要在AI领域实现新的技术突破以及持续的收入增长,才能保持市值的领先地位。