华人科学家20年研究,又有了新成果。

进入2024年,AI 的膨胀速度依然让人惊叹。

但也有一些人认为,AI对于电力的恐怖需求,未来会限制它的发展速度,“AI的尽头是算力,而算力的尽头是电力”。

有研究机构根据英伟达出货情况进行估算,目前OpenAI大约需要3617个英伟达A100计算平台来支持其ChatGPT的使用,而这些计算平台所包含的GPU,每天的总能耗高达564MWh,即56.4万度电。

而这仅仅是OpenAI一家公司,随着谷歌、Meta等公司逐渐全盘AI化,,其总体能耗将会是一个令人震惊的数字。

AI芯片消耗的电量主要出现在模型训练和推理两方面,但实际上,AI芯片在进行计算时,会在处理器和内存单元不断来回移动数据,这同样是一个耗能的过程。一项降低功耗的新技术

近日,明尼苏达大学双城校区的研究人员对外宣布设计了一种全新的“计算随机存取存储器”(CRAM:computational random-access memory)原型芯片。

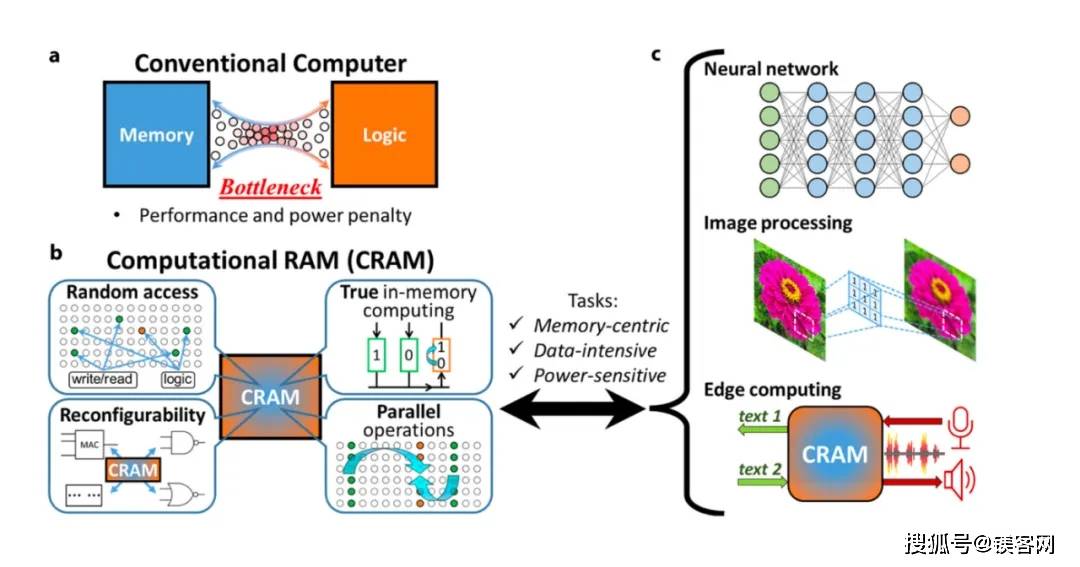

和传统的冯·诺依曼架构不同,这是一种“存算一体”架构,它使用称为磁隧道结 (MTJ) 的自旋电子器件,可以直接在内存内部进行计算,由于自旋电子设备并不依赖电荷来存储数据,而是利用电子自旋,因此可以替代传统的基于晶体管的芯片。

此外,根据研究团队公布的论文示例图,我们可以注意到这种新型存储器是通过将数据保存在内存阵列内进行来处理,数据无需离开计算机存储信息的网格,从而解决传输数据时产生。

该团队表示,和传统冯·诺依曼架构相比,基于 CRAM 的机器学习推理加速器能耗可降低至千分之一,甚至在某些场景应用下可以达到 1/1700 或者 1/2500。在能源需求激增的AI时代,这种新技术无疑对提升能源效率起到至关重要的作用。

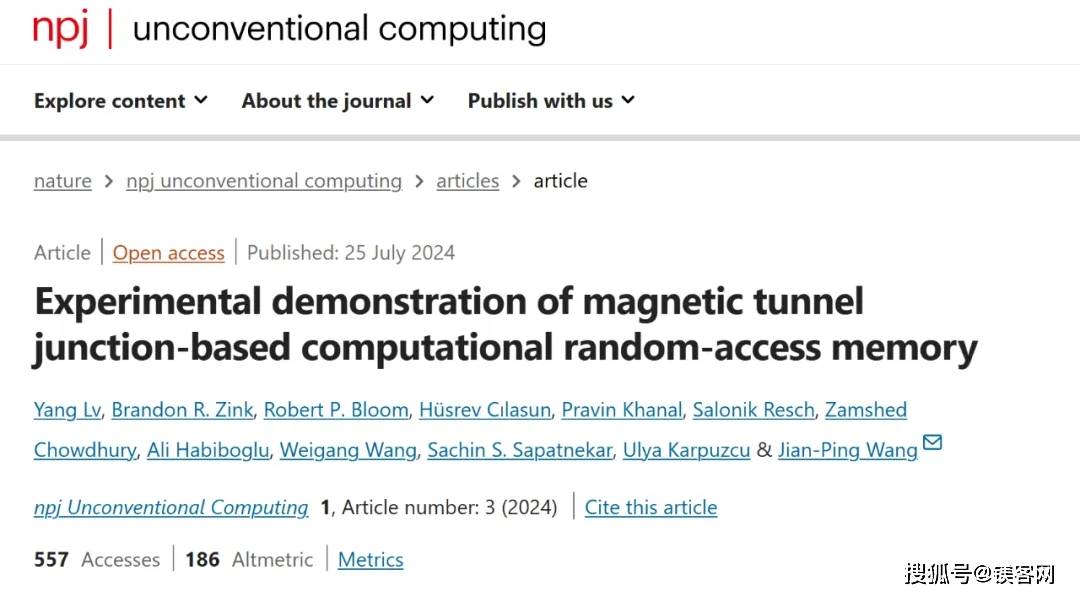

目前,该研究已经发表在《自然》杂志的同行评议科学期刊 《npj Unconventional Computing》上,研究人员称拥有该设备所用技术的多项专利。从报道可知,这项研究已经酝酿了20多年,并且与明尼苏达大学理工学院王建平博士有很大关系。

王建平教授是新型磁性材料和自旋电子器件领域的世界知名专家,侧重于信息存储、记忆和计算以及生物医学传感方向的研究。

自 2008年以来,王建平通过交换耦合复合介质(ECC)的开创性实验演示,高效利用了HDD硬盘驱动器的技术,有效减少数据中心的整体数量,节约了全球能量消耗。

同时,王建平正是计算机随机存取存储器(CRAM)记忆单元的发明者。但在二十年前,他们提出抛弃冯·诺依曼模型的提议,无疑是被认为是“疯狂的”。

但最终他们团队还是坚持了下来,其发明的MTJ 器件已被英特尔、美光等公司变成了商业产品。

目前,该团队一直计划与明尼苏达州当地半导体企业合作,提供大规模演示并生产硬件以推进AI功能。存算一体,何时能火

存算一体架构的优势,其实就是打破了“存储墙”和“功耗墙”问题。

前者指的是存储器的性能跟不上 CPU 的性能,从而影响了系统的整体性能。而后者就是开头提到的数据在处理器和存储单元之间传输会产生的巨大功耗。

除此以外,存算一体架构可以直接在设计时就为特定领域的计算问题提供更大的算力,非常适合于当下的AI计算乃至未来更大规模的数据处理。

但值得一提的是,存算一体并不是什么新事物,而到目前该架构也未形成统一的技术路径,主流的包括近存计算(PNM)、存内处理(PIM)、存内计算(CIM)三种。

而存算一体芯片所面临的挑战也非常多,例如依赖先进的封装技术以此在芯片内部实现更高的密度,而目前的一线封装大厂已经很难再挤出产能。

此外,在芯片设计方面,存算一体芯片对架构设计的难度和复杂度要求很高,市面上也缺乏成熟的EDA软件以及测试软件。

最后就是在生态方面,目前无论是芯片大厂还是创业公司,各厂商开发出来的芯片都是围绕自行定义的编程接口,软件生态基本做不到互相通用,极大的影响了存算一体芯片推广使用。

因此在目前电能资源还算充裕的前提下,存算一体芯片还是很难替代现有的AI芯片。